Le référencement naturel, jusqu’ici, n’avait en fait rien de naturel.

Si être bien référencé naturellement signifie être dans les trois premières positions de la première page de Google, alors on est forcé de constater que le triangle d’or – comme on a coutume d’appeler les trois premiers résultats d’une recherche – est très souvent squatté par les sites qui se préoccupent plus de leur référencement naturel que de la légitimité de leur contenu à être sur le tant recherché podium. Bien souvent ces sites ont investi dans diverses actions de référencement, que ce soit on-site (optimisation technique, stratégie de contenu…) ou off-site (netlinking, réseaux sociaux…).

On devrait donc plutôt parler de référencement artificiel, et non pas de référencement naturel ; et comme Google associe de plus en plus d’actions SEO à du webspam, le référencement naturel – enfin artificiel – ne serait-il pas en train de devenir black-hat ?

Même si certaines des dernières pénalités attribuées par Google me paraissent excessives (je pense notamment au cas de docsheldon.com), je trouve que jusqu’ici il y a une certaine logique dans les modifications apportées par Google à son algorithme.

Celui qui a le souci d’être visible sur Google devrait en premier lieu se soucier du bénéfice qu’il apporte à son visiteur, et c’est bien dans ce sens là que Google fait évoluer les résultats qu’il met en avant.

En fait, la question que je veux soulever dans cet article, c’est peut-on vraiment encore parler de référencement ou de SEO ?

Ok, il y aura toujours du travail à faire en terme d’optimisation de sites (virer les éventuelles 404, vérifier l’unicité des balises title, des méta-description, réduire les temps de chargement, etc), mais peut-on vraiment encore faire plus que ça sans risquer de se faire griller par Google ?

Je m’explique : et si Google avait décidé que désormais, le référencement d’un site doit être naturel pour de vrai. Si il ne servait plus à rien, voire s’il devenait néfaste, de s’occuper du référencement d’un site.

Avant d’entrer plus en profondeur dans ma réflexion, je vous propose un petit retour en arrière.

Sommaire

Le septième jour, Google créa le SEO

Si Google est devenu Google, c’est grâce à cette idée simple qu’il a intégrée à son alogrithme : prendre en compte le nombre de liens qui pointent vers un site.

Quand Yahoo ou Altavista ne se souciaient que des meta-descriptions et meta-keywords pour indexer un site web, Google a prit en compte un nouvel élément qui allait permettre d’améliorer considérablement la qualité des résultats présentés aux internautes : la notoriété d’un site (calculée donc en fonction de la quantité de liens pointant vers son contenu).

Pas con… Si un site reçoit de nombreux liens, c’est qu’il présente un intérêt.

Et voilà comment est né le SEO. Il allait maintenant falloir avoir – et créer si nécessaire – des liens pour être bien référencé chez Google. Ainsi, Google créa le SEO, et le webspam : inscriptions massives dans les annuaires, sites satellites…

Créer des liens artificiels pour être bien référencé naturellement. Vous voyez la contradiction ?

Mais Google n’est pas con (comme je le disais un peu plus haut). Je dirais même qu’il faut être con pour prendre Google pour un con (ça fait beaucoup de fois le mot con je sais…)

C’est pourquoi rapidement Google a modifié son algorithme et a pris en compte la qualité des liens entrants.

Les annuaires de référencement sont morts

Les annuaires de référencement sont morts de chez morts. En tout cas, ils agonisent et leur tombe est déjà creusée selon moi.

D’ailleurs je trouve ça dingue que les annuaires tiennent encore un rôle aujourd’hui dans l’algorithme de Google.

Google veut que le webmaster se soucie de son visiteur, or ce n’est pas parce qu’un site est bien référencé dans les annuaires qu’il a le souci de son visiteur. Pourquoi un autre webmaster – qui n’aurait pas référencé son site dans les annuaires du fait qu’il consacre son temps à la qualité de son site – devrait être moins bien positionné ?

Volià donc pourquoi je suis sûr que bientôt Google va supprimer toute crédibilité aux annuaires en terme de netlinking.

Il y a quelques mois, j’ai eu un entretien pour un poste de Cosnultant SEO au sein d’une agence web. L’objectif du poste étant de développer l’offre SEO, le boss m’a demandé

– « Ok, et en netlinkg vous êtes bon ? Vous gérez ? Quelles techniques vous utiliserez pour nos clients ? »

Je lui ai répondu :

– « Aucune »

Et je lui ai expliqué pourquoi je ne croyais plus au netlinking, et même comment on pourrait l’utiliser comme argument commercial (genre « nous on est une agence white-hat »).

Le lendemain matin, le boss m’a rappelé et m’a dit :

– « Valentin, quand est-ce que tu peux commencer ? » (cool hein 🙂 )

Finalement, j’avais plutôt bien argumenté mon idée qui lui paraissait pourtant contradictoire à l’offre de ses concurrents.

Mais après tout, un lien dans un annuaire est tout sauf un lien naturel.

Alors c’est vrai, vous allez me dire :

– « Oui mais il faut faire la différence entre un mauvais annuaire et un bon annuaire ».

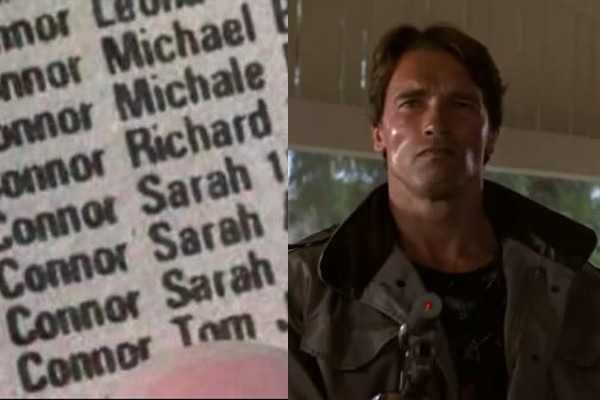

La différence entre un bon annuaire et un mauvais annuaire

Le bon annuaire, il fait un lien vers ton site…

Le mauvais annuaire, il fait un lien aussi, mais c’est pas pareil…

Non, plus sérieusement : c’est vrai qu’il existe de meilleurs annuaires que d’autres, et surtout des annuaires à éviter. Mais on ne va même pas s’attarder à faire la différence, pour moi les annuaires, c’est du référencement artificiel, ce n’est pas du référencement naturel. Et je ne vois pas quel avenir un annuaire peut avoir dans un monde où Google existe.

Voilà mon opinion : il n’y a pas de bons annuaires, que des annuaires qui peuvent un jour ou l’autre, du jour au lendemain, nous péter à la gueule.

Et donc le Netlinking est mort ?

Bah non le netlinking n’est pas mort, le netlinking ne passe pas que par les annuaires, et ça fait d’ailleurs longtemps qu’ils occupent une place de second rang. Il est évident que le netlinking reste un point essentiel au référencement de tout site web.

Cependant je ne crois plus aux stratégies de netlinking classiques, ça a changé. Ce n’est plus comme avant. C’est trop dangereux.

Non seulement c’est trop dangereux, mais en plus le netlinking est certainement le travail qui bouffe le plus de temps au référenceur.

Et si Google décidait de pénaliser les sites possédant des liens dans de nombreux annuaires ?

Je sais que ça a déjà été le cas pour certains sites, mais ceux qui ont reçu des pénalités avaient mis en oeuvre des pratiques de bourrins à base d’inscriptions automatiques dans des centaines d’annuaires en une journée. Google sait très bien estimer le nombre de backlinks que peut générer un site sur une période donnée (en fonction de son trafic, de son ancienneté et de tout une ribambelle d’autres critères).

Mais je ne vous parle pas d’inscriptions massives dans des annuaires. Je vous parle de ce travail méticuleux et calculé, encore trop souvent considéré comme indispensable, d’inscriptions dans des annuaires bien choisis, à intervalles réguliers, et qui bien souvent constitue le travail des agences SEO.

Vous imaginez les boules quand on connaît le travail que représente l’inscription d’un site dans des annuaires (de belles descriptions différentes pour chaque annuaire, de belles ancres bien pensées sur des liens profonds…) ; vous imaginez les boules pour une entreprise quand on voit le montant que facture une agence de référencement pour deux à trois inscriptions mensuelles dans des annuaires de « qualité » pendant un an ; vous imaginez les boules quand non seulement cet investissement est anéanti, mais qu’en plus il se retourne contre vous.

Payer pour être moins visible, ça vous tente ?

Personnellement, à partir du moment où il est envisageable qu’une telle stratégie se retourne contre mon site ou celui de mon client, et quand on voit à quel point cette activité est chronophage, je ne pense pas que ce soit une bonne idée de travailler le référencement (enfin le netlinking) avec des annuaires. Mieux vaut produire du contenu qui se partage, miser sur le linkbaiting (là encore en étant le plus naturel possible) ou sur les réseaux sociaux. Mieux vaut passer un peu de temps à optimiser son site, à repasser sur les pages pour mieux les positionner sur certains mots clés.

Mieux vaut mettre en place une stratégie naturelle pour de vrai.

Mieux vaut rentrer dans le rang ; se ranger.

Ensuite je sais, vous pouvez aussi me dire que c’est comme les systèmes d’alarme et les cambrioleurs. Plus on fait des systèmes d’alarme perfectionnés, plus les cambrioleurs développent leur façon de travailler. C’est un peu pareil pour le référencement : plus Google fait évoluer son algorithme, plus il faut filouter.

Mais Google n’aime pas les filous

On connaît les dangers de la suroptimisation du référencement. Et si à l’avenir il y avait un danger à l’optimisation du référencement ?

Aujourd’hui, respecter rigoureusement les règles identifiées du référencement me paraît dangereux.

Google, c’est la machine la plus intelligente de la planète

Vous avez vu, il y a peu Google a modifié l’affichage de ses pages de résultats. Désormais la police des titres est plus grosse. Il en résulte que les titres des résultats affichent moins de caractères. Au lieu des 70 caractères affichés avant, il n’y en a plus qu’une cinquantaine. Alors quel est le bon nombre de caractères aujourd’hui ? Et bien il ne s’agit plus de nombre de caractères mais de nombre de pixels, et comme chaque lettre ne fait pas le même nombre de pixels (un w est plus grand qu’un i), le travail d’optimisation d’un titre en fonction des mots clés, des majuscules, et de la taille des lettres, complique autrement le travail du titrage d’une page.

Le mec qui a fait un travail sur les titres de ses 500 articles pour qu’il fassent tous 70 caractères, bah Google l’a envoyé se faire f…

Et si Google allait encore plus loin ?

Et si Google était en train de tuer le SEO ?

Allons plus loin : et si Google faisait semblant de tuer le SEO pour s’approprier définitivement Internet ? Là aussi il faut que j’explique ma pensée.

Ces derniers temps, Google s’est beaucoup exprimé au sujet du SEO, beaucoup de sites ont été pénalisés comme Buzzea ou MyGuestBlogging, instaurant ainsi une politique de l’incertitude, même de peur. Mon site va-t-il être pénalisé parce que j’ai des auteurs invités ?

Tout le monde se tient à carreaux, et tout le monde retient son souffle à chaque tweet de Matt Cuts.

Non seulement Google fait des modifications intelligentes à son algorithme pour remettre en place les filous, mais il rend aussi son robot d’indexation de plus en plus intelligent. Alors jusqu’où l’intelligence de Googlebot ira sachant que Google s’intéresse de très près à l’intelligence artificielle ?

Et si tout ça n’était qu’une tactique pour imposer Google Plus ?

L’AuthorShip de Google Plus a remis le contenu au centre du web, et même au centre de toute stratégie de référencement. Pour être bien référencé, il faut produire du contenu ; du coup tout le monde produit du contenu. Mais dans cette surabondance de contenu, pour être bien indexer, il faut être sur Google Plus. Je pars loin hein… héhé oui c’est vrai mais j’aime bien me creuser la tête. 😉

Il ne s’agit plus de référencement, mais de visibilité

Les réseaux sociaux ont considérablement changé la donne pour les entreprises, désormais être bien référencé c’est bien, mais il faut aussi avoir un trafic en provenance des réseaux sociaux.

Il ne faut plus penser référencement, il faut penser visibilité, trafic, et bien sûr conversion.

La visibilité sur le web, ça passe évidemment par un bon référencement dans les moteurs de recherche, mais c’est aussi une présence sociale intelligente capable de générer de l’engagement, d’émettre des signaux en provenance de différents réseaux sociaux.

Aujourd’hui, c’est l’internaute qui rend visible un site web.

C’est donc l’internaute qu’il faut réussir à placer au centre de sa stratégie de visibilité, en lui offrant un contenu de qualité, un confort de navigation, et en provoquant l’envie de partager et diffuser son contenu.

Pour conclure cet article, je dirais qu’il ne faut pas trop – en tout cas de moins en moins – se soucier de l’algorithme de Google. Le référencement, dans la plupart des cas, c’est nécessairement une stratégie de long terme. Axer le référencement d’un site web uniquement sur les techniques qui fonctionnent avec l’algorithme actuel de Google, c’est penser à court terme, et penser à court terme est une mauvaise technique.

Il faut être plus malin que ça… Même si Google n’aime pas les filous 😉

Un article très riche et pertinent sur l’évolution du référencement.

J’ai adoré l’illustration de « la différence entre un bon et un mauvais annuaire » 🙂

Merci Guinel ! C’est vrai que j’ai été inspiré pour les illustrations de cet article 😉

Très,très bon article, j’ai pris plaisir à lire. Ayant ouvert un blog depuis peu, j’ai lu pleins d’articles pour faire connaître son blog. Je me suis inscrit à quelques annuaires.

Cependant,l’impact est vraiment minime quant à élever la popularité de son blog.

Par contre,les réseaux sociaux prennent une part de plus en plus iimportante. Au départ, il est difficile de voir le nombre de personnes peu élevé sur son blog.

Mais.il faut laisser le temps au temps, c’est un travail qui se fait sur le temps et quand on a compris ça, on est plus serein !

Bonjour,

Voilà un article plein de bon sens et qui reflète à 100% la vision que j’ai de ce qu’est devenu le SEO.

Premièrement à propos du SEO externe. Sur 2013/2014 le SEO a vraiment changé en profondeur et avec une rapidité inconnue jusqu’alors. Au lieu de créer artificiellement de la popularité, ce que, personnellement, j’ai fait entre 2003 et 2012, on doit maintenant préconiser aux clients des actions qui visent à créer de la popularité réelle, charge au SEO d’avoir prévu un site assez bien optimisé pour que ça se « transmette » bien sur tout le site. La nuance est subtile mais dans les faits ça change énormément de choses.

Le SEO on site a, lui, encore la vie belle sur les gros sites. Tant que Google aura des crawleurs et pour les sites à gros volume de pages, il faudra optimiser la performance, avoir un site « propre », limiter la consommation en bande passante, etc.

Tant que l’info sera analysée par des machines qui ne peuvent qu’estimer si un contenu est pertinent et de quoi il parle, s’il est mis ou non en avant sur le site, il faudra créer des arborescences optimisées, faire des ponts entre les contenus, enrichir le contenu, etc.

Il faudra également toujours penser le site avec cette idée que toute page est une landing.

En somme, l’avenir est de s’occuper du site en lui même, de l’optimiser pour les contraintes des robots, de le penser utilisateur. A ce propos il est tout de même dommage pour notre métier d’avoir du attendre 2014 pour que la masse des consultants parle enfin naturellement d’Ux, d’attrait du site en lui même, de taux de conversion, etc. (je fais partie de ce que je critique ici). Reste à savoir quelle est la pertinence d’un consultant SEO à donner des préco en matière de merch, Ux, design, etc. alors que c’est l’expertise d’autres qui font ça depuis des décennies…

Dans tous les cas, je trouve que le moteur évolue vraiment dans le bon sens pour l’utilisateur. A cause de Google les SEO ont passé 15 ans à pourrir le web, maintenant que Google devient pertinent, c’est l’heure du ménage.

François-Olivier

Propos auquel j’adhere, ceci etant je me demande ce que Google va nous sortir prochainement. Recemment, les resultats sponsorises devenaient quasi identiques aux resultats naturels dans les serp. Google+ est pousse en avant. Rien n’empeche la firme californienne de pousser a son avantage et je me demande jusqu’ou elle ira dans la preference donnee a son modele economique, versus des serp qui differenciait clairement le payant du naturel.

@ Alexis : Merci pour ton commentaire. C’est vrai que c’est difficile : lorsqu’on vient de créer son blog, on a un peu l’impression de parler tout seul. Mais peu à peu, si on traite ses sujets de manière intéressante et surtout différente, alors les visites se multiplient. Comme tu le dis très bien il faut laisser le temps au temps.

Il ne faut pas oublier qu’un blog, au départ, c’est un journal perso, il faut aborder ses sujets de manière personnelle, à la première personne ; ce n’est plus un site que l’internaute lit, c’est une personne qui lui parle. C’est le sentiment qu’il faut essayer de transmettre à travers un blog pour créer de l’engagement.

Bon courage pour ton blog, le mien aussi est tout nouveau 😉

@ François-Olivier : Merci pour ces développements 🙂

Effectivement il y aura toujours du taf on-site, surtout pour les gros sites comme tu le dis.

Concernant la pertinence du SEO à donner des conseils en terme d’expérience utilisateur, de design etc, pourquoi pas ? Un site optimisé, c’est forcément un tout, donc (avis perso) je pense que oui, le SEO doit se préoccuper de ces aspects là et quand il n’a pas (encore) une expertise poussée sur ces questions, alors il devrait les développer.

@ Jean-Sam : Ce qui est sûr, c’est que le web est en train de changer, et que Google+, les mobiles, et les données structurées, vont prendre de plus en plus d’importance. C’est dans ce sens là que je creuse de mon coté 😉

Les résultats sponsorisés identiques aux résultats « naturels » (je mets des guillemets du coup), ça dépend quand même des requêtes. Je ne pense pas que Google ait intérêt à lier les deux.

Bonjour, les annuaires comme le Guest blogging, c’est du pur artificiel…Google les excluront de sa recherche primaire.

Perso, le SEO réfléchi est né, en favorisant le netlinking uniquement en se basant sur le principe du fonctionnement du naturel, c’est à dire de lier avec un blog/site ayant une relation directe (et non au second degré) avec la thématique principale du site client. Et pour cela, il existe plusieurs manières d’y arriver.

Merci pour ton article, c’est long…mais utile surtout pour commencer à gérer le netlinking d’un site en 2014.

Très bon article qui reflète ma pensée… On ne doit plus parler de référencement, mot qui était déjà utilisé a mauvais escient. On doit parler de visibilité mais aussi de sa pertinence avec le retour sur investissement en analysant les visiteurs. en ce qui concerne Google, le travail se fait lentement mais surement vers le « naturel ». La réputation des auteurs et éditeurs, le référencement local, l’analyse du contenu des sites et réseaux sociaux sont autant d’indicateurs permettant de contrer les artifices. Le métier de « SEO » existe toujours mais celui ci devra plutôt optimiser la visibilité car les techniques évoluent rapidement et vérifier que le client ne soit pas pénalisé.

Merci pour l’article. Etant à la base intégrateur, j’ai un penchant pour le on site, le WPO, le bon code bien sémantique et les interfaces pensées utilisateur. Difficile de garder la foi quand les sites des SEOs « linkbluilders » continuent d’occuper souvent les premières places … Malgré cela, je pousse mes clients vers la création de contenu, et pour faire passer la pillule, j’ai l’habitude de les dire que « Google a tout l’intérêt à proposer des sites utiles, sinon qui l’utiliserait ? » (tous n’y croient pas). En tout cas, une page de contenu intéressant ne se retournera pas contre eux.

@ Ulan : Le « SEO réfléchi », voilà une expression à méditer 😉

@ Abitasud : Oui je pense aussi que le SEO est simplement en train de changer. Il semble évident que Google à complètement repensé sa manière d’indexer les contenus et que brique à brique, on se dirige vers un moteur de recherche très différent.

@ Victor Vila : Bien souvent le problème avec les clients, c’est qu’ils veulent des résultats très rapidement. Difficile de leur faire comprendre, quand beaucoup vendent du rêve, que le référencement est un travail d’entretien sur le long terme. Cela dit ils finiront bien par comprendre.

Merci pour vos commentaires 🙂

Disons qu’au départ, le référencement est destiné à améliorer l’accessibilité des sites pour les robots.

Le problème commence lorsqu’on optimise pour le positionnement.

L’éternel dilemme est que ça marche le concept de « faire du contenu de qualité et le reste suivra », sauf que ce n’est pas aisé.

Du coup, forcer plus ou moins le naturel reste la meilleure option.

Normal que les moteurs progressent à détecter les abus, mais on a encore beaucoup de marge. Il est toujours possible de forcer le naturel en diminuant le facteur risque.

@ Laurent Bourrelly : Merci pour ces remarques. C’est vrai que que le contenu de qualité est de moins en moins suffisant.

« Forcer le naturel en diminuant le facteur risque », on reconnaît bien la philosophie d’un SEO efficace et oui on a encore de la marge, mais pour combien de temps ? Est-ce qu’un risque minime aujourd’hui le sera encore demain en fait ? Tout dépend du risque sûrement mais dans la perspective d’un référencement vraiment naturel, la question peut se poser.

Surprenante, mais agréable lecture du vendredi matin ! Merci pour cet article très instructif, qui conforte mon idée sur le « référencement naturel »

Depuis plusieurs mois je m’affaire à produire du contenu de qualité sur mon propre blog sans allez publier des communiqués de presse sur des sites bancale et je travail aussi sur l’optimisation ou plutôt le contrôle de l’optimisation de mes sites sans allez jusqu’à la sur-optimisation qui m’a déjà été fatale 🙁

En fonctionnant ainsi je ressent une hausse du nombre de visiteurs et donc un meilleur classement dans les résultats de recherches.

Merci pour ce retour Anthony, et bon courage pour le travail de tes sites.

Personnellement depuis que j’ai arrêté le SEO pour mes propres sites, j’ai largement augmenté mon nombre de visiteurs utiles. Je dit utiles car en terme de trafic pur j’ai un volume moins important qu’avant mais les prises de contact, commentaire et autre interaction sont beaucoup plus nombreuses.

Pour moi c’est tous simple, ne pas tenir compte de Google (et donc du SEO) c’est la meilleure manière de monter dans les SERP.

Il faut ré-utiliser naturellement tous ce qui a été détourné par le SEO.

– Le guest blogging: pour toucher des lecteurs qui ne connaissent pas encore notre blog

– les réseaux sociaux: pour créer et animer un réseau

– les CP: pour promouvoir

– les annuaires (c’est comme les CP)

– la création de contenu: pour démontrer son expertise (et il faut pas hésiter à varier les support: article, vidéo, etc…)

Et au final que Google fasse ce qu’il veut, même s’il me banni j’aurai des visites déjà par mes propres actions, google c’est que du bonus :).

Très bon article ! Il reflète bien ma vision sur référencement naturel ! Je like !

@ Olivier Clémence : Merci pour ton commentaire. C’est sûr qu’il vaut mieux avoir un trafic moindre qui soit qualifié et qui convertit mieux qu’un trafic plus conséquent mais mal ciblé. C’est un peu l’histoire des 200 fans engagés qui valent mieux que 2000 fans à l’ouest.

Ensuite le seo n’est pas mort, il y aura quand même toujours un travail à faire pour améliorer le référencement d’un site, c’est juste que ce travail change avec les évolutions des moteurs de recherche. Au fil du temps, il y a de plus en plus de méthodes qui deviennent risquées et donc on est obligé d’utiliser des techniques de plus en plus naturelles.

Comme le dit très justement Laurent, le SEO a commencé par l’optimisation de l’accessibilité des contenus aux bots, voyant les faiblesses de l’algo les SEO ont ensuite optimisé pour le positionnement. Petit à petit, puis récemment tout d’un coup, Google a largement amélioré la qualité de ses analyses et maintenant se prémunis très bien contre l’optimisation pour le positionnement.

On va revenir à l’optimisation d’accessibilité pour les bots. Donc du build, de la croissance par la landing / le contenu.

La question est : combien d’agence vont survivre ?

[…] y a une telle masse de contenus sur le web, et tout le monde usant des mêmes stratagèmes SEO pour bien se positionner, qu’il est difficile de sortir du lot sur le moteur de recherche […]

Vraiment un article plein de bon sens et fort pertinent. Merci !!!

Merci Samira !

[…] Un article qui clique, c’est aussi un article bien référencé. Il faut donc avoir à l’esprit quelques règles de rédaction qui faciliteront votre référencement naturel. […]